Uruchamiasz nową stronę internetową. Projekt dopięty na ostatni guzik, treści gotowe, a Ty czekasz na pierwszych użytkowników z wyszukiwarki. Mija dzień, tydzień, a Twojej witryny wciąż nie ma w wynikach Google. Pojawia się niepokój i pytanie – dlaczego?

Pierwsze bariery: robots.txt i meta tag noindex

Kiedy strona nie pojawia się w Google, najpierw warto sprawdzić najbardziej podstawowe blokady.

Robots.txt – mały plik, duże znaczenie

Robots.txt, czyli plik znajdujący się w katalogu głównym Twojej witryny. To coś w rodzaju drogowskazu dla robotów wyszukiwarki. Dzięki niemu możesz wskazać, które sekcje serwisu są dostępne do skanowania, a które pozostają poza zasięgiem indeksacji.

Najczęstszy błąd polega na tym, że podczas tworzenia strony, deweloperzy wprowadzają blokadę dla wszystkich robotów, aby uniknąć przedwczesnego indeksowania wersji testowej. Problem w tym, że często zapomina się tę blokadę zdjąć po uruchomieniu serwisu.

Fragment, który powoduje kłopot, wygląda tak:

Taki zapis odcina całą witrynę od robotów wyszukiwarki. Jeśli znajdziesz go w pliku robots.txt, masz odpowiedź na pytanie, czemu Google nie widzi Twojej strony.

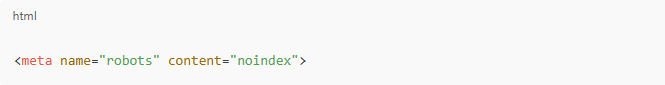

Meta tag noindex – niewidoczna bariera

Drugim elementem, który potrafi skutecznie zatrzymać indeksację, jest meta tag noindex. To instrukcja umieszczona w kodzie strony, informująca Google, by nie dodawał jej do wyników wyszukiwania.

Wygląda tak:

Często stosuje się go podczas prac nad stroną, podobnie jak robots.txt. Jeśli jednak zostanie przypadkowo włączony w wersji produkcyjnej, Twoja witryna pozostaje niewidoczna dla wyszukiwarki.

Podobne: Certyfikat SSL – co to jest i dlaczego jest tak ważny?

Cierpliwość – gdy strona jest nowa

Załóżmy, że wszystko masz ustawione poprawnie. Robots.txt nie blokuje dostępu, a w kodzie nie ma tagu noindex. Witryna jednak nadal nie pojawia się w Google.

W takiej sytuacji przyczyną może być zwyczajnie… czas.

Google codziennie przetwarza miliardy nowych podstron. Według raportu Internet Live Stats, każdego dnia w sieci pojawia się średnio 252 000 nowych witryn. Twoja jest jedną z nich. Roboty wyszukiwarki muszą do niej dotrzeć, przeskanować ją i zdecydować, czy warto dodać ją do indeksu. Proces ten potrafi zająć od kilku dni do kilku tygodni.

Dlatego świeżo uruchomione serwisy powinny uzbroić się w cierpliwość. Oczekiwanie nie oznacza jednak bezczynności – można bowiem wspierać proces indeksowania.

Jak wspierać proces indeksowania? 5 metod!

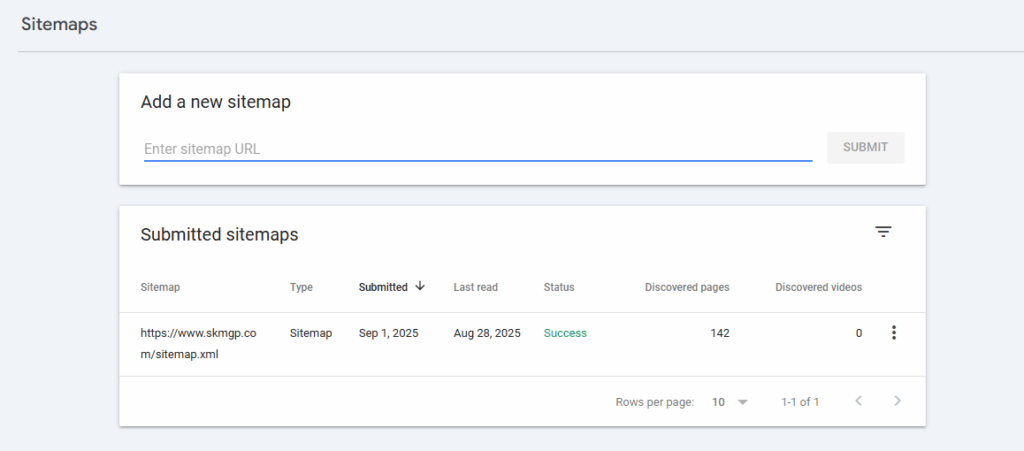

Metoda 1: Mapa strony w Google Search Console

Mapa strony (sitemap.xml) to specjalny plik zawierający listę wszystkich adresów URL, które chcesz indeksować. Za jego pomocą roboty otrzymują jasną instrukcję: tu są moje treści, zajrzyj i dodaj je do indeksu. Dodanie mapy w Google Search Console to jeden z najprostszych sposobów na przyspieszenie indeksacji.

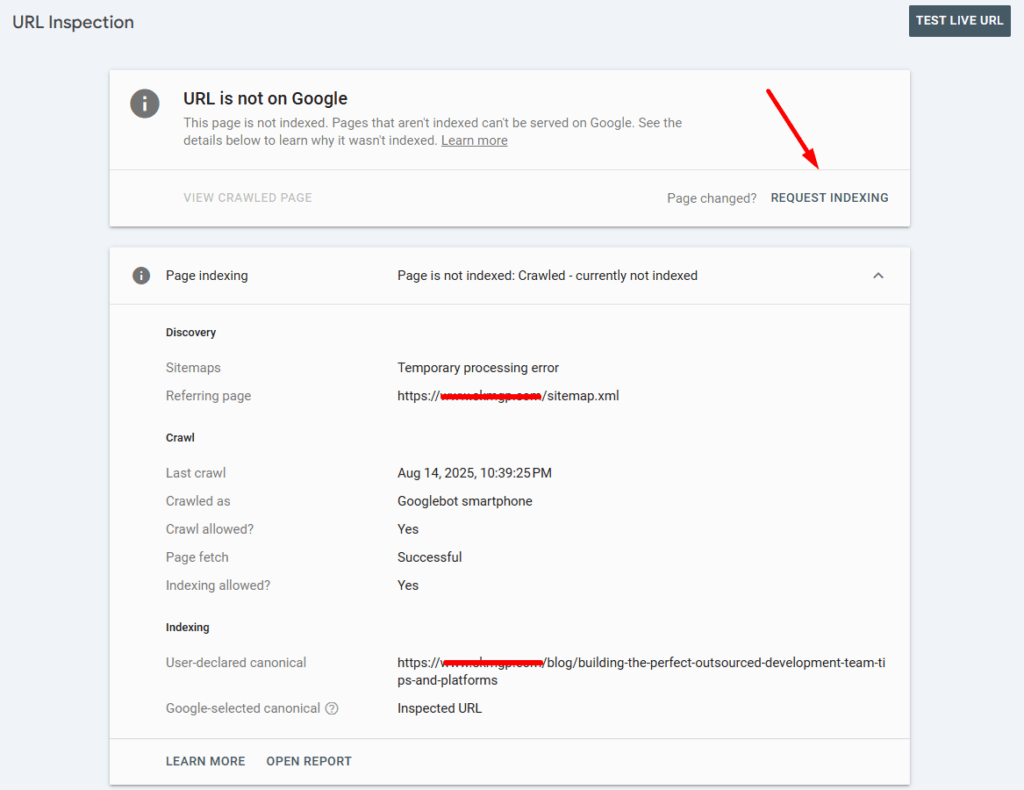

Metoda 2: Ręczne zgłoszenie adresu URL

Google Search Console oferuje także funkcję ręcznego zgłaszania pojedynczych stron do indeksowania. Wystarczy wkleić adres w odpowiednie pole, żeby robot otrzymał sygnał, że pojawiła się nowa treść. Nie gwarantuje to natychmiastowej obecności w wynikach, ale znacząco zwiększa szanse na szybsze zauważenie witryny.

Metoda 3: Linkowanie wewnętrzne

Roboty Google poruszają się po sieci, podążając za linkami. Jeśli nowa strona została dobrze osadzona w strukturze witryny – czyli prowadzą do niej odnośniki z innych, już zaindeksowanych podstron – proces dodania jej do indeksu przebiega sprawniej.

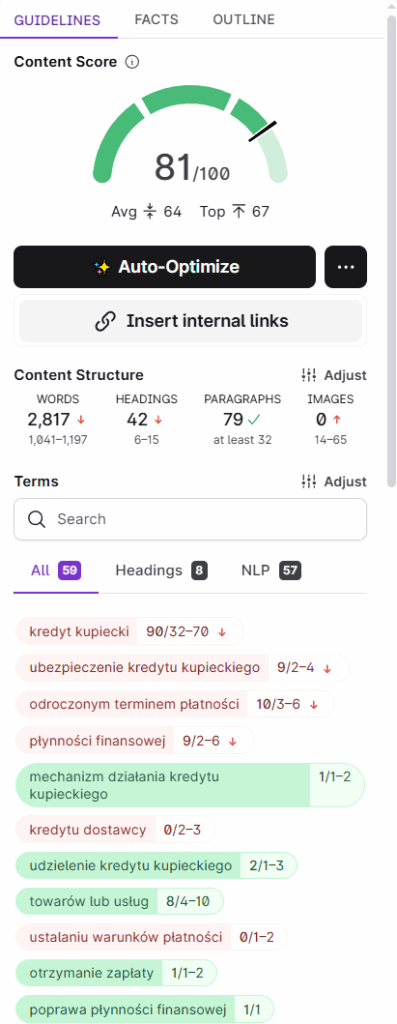

Metoda 4: Wartościowy i unikalny content

Treść to podstawa. Algorytmy Google niechętnie dodają do indeksu strony, które mają skopiowaną zawartość z innych miejsc lub oferują bardzo mało tekstu. Jeśli Twoja witryna prezentuje rzetelne, unikalne informacje, szansa na szybkie zaindeksowanie rośnie.

Metoda 5: Linki zewnętrzne

Link building, czyli zdobywanie odnośników z innych witryn. Gdy Google trafi na link prowadzący do Twojej strony, traktuje go jako wskazówkę, że warto ją odwiedzić. Zgodnie z badaniami Backlinko, strony posiadające więcej odnośników zewnętrznych są częściej i szybciej indeksowane.

Google też się myli

„Nawet jeśli wszystko masz ustawione poprawnie, Twoja strona jest wartościowa i aktywna, może zdarzyć się, że Google… zawiedzie. Algorytmy wyszukiwarki są rozbudowane, ale nie doskonałe. Czasami pojawiają się błędy w systemach indeksujących. Zdarzało się już, że miliony stron na całym świecie wypadały z wyników na skutek awarii po stronie Google. Dlatego, jeśli Twoja witryna nie pojawia się w indeksie, nie zawsze winny jesteś Ty. Czasem to kwestia chwilowych problemów technicznych po stronie wyszukiwarki.

Jakość treści a decyzja Google o indeksowaniu

Google od dawna podkreśla, że nie każda treść zasługuje na miejsce w indeksie. Algorytmy filtrują strony, które nie wnoszą wartości. Co to oznacza w praktyce?

Zbyt mało treści

Jeśli podstrona zawiera kilka zdań, a całość przypomina notatkę bez rozwinięcia, wyszukiwarka może uznać, że nie warto jej dodawać. W branży SEO mówi się o stronach „thin content” – takich, które mają za mało informacji, aby były użyteczne.

Powielona zawartość

Kopiowanie treści z innych stron to droga donikąd. Google szybko rozpoznaje duplikaty i nie widzi powodu na utrzymaniu wielu identycznych wersji. Efekt? Brak indeksacji lub pominięcie strony przy wyświetlaniu wyników.

Treści niskiej jakości

Google w ramach wytycznych „Search Quality Evaluator Guidelines” kładzie nacisk na tzw. E-E-A-T (doświadczenie, wiedza ekspercka, autorytet, wiarygodność). Strony pozbawione tych cech są traktowane jako mało wartościowe. Musisz dostarczać treści rzetelne, spójne i napisane dla człowieka.

Analiza logów serwera – co mówią dane techniczne?

Czasem problem tkwi nie w treści, lecz w technicznej komunikacji pomiędzy stroną a robotami wyszukiwarki.

Dlaczego logi są ważne?

Pliki logów serwera pokazują, jak roboty Google odwiedzają witrynę. Z danych można wyczytać, które adresy są skanowane, jak często robot powraca i czy napotyka błędy.

Za pomocą logów odkryjesz m.in.:

- strony, które Googlebot próbuje odwiedzić, ale otrzymuje błąd 404;

- podstrony ignorowane przez robota, mimo że istnieją w strukturze serwisu;

- częstotliwość wizyt Googlebota (umożliwia to ocenę, czy witryna jest wystarczająco atrakcyjna technicznie).

Struktura witryny i problemy techniczne

Jeśli do ważnej podstrony prowadzi droga przez 5 czy 6 kliknięć, robot może uznać, że nie jest to istotne miejsce w serwisie. Dlatego ważne okazuje się budowanie płaskiej struktury – czyli takiej, gdzie najważniejsze sekcje są dostępne w maksymalnie 3 krokach od strony głównej.

Błędy w adresach kanonicznych

Adres kanoniczny (rel=„canonical”) wskazuje wyszukiwarce, która wersja strony jest tą główną. Niewłaściwe użycie tego znacznika sprawia, że Google pominie daną podstronę. Jeśli ustawisz canonical na inną stronę, to właśnie ona trafi do indeksu, a Twoja zniknie z pola widzenia.

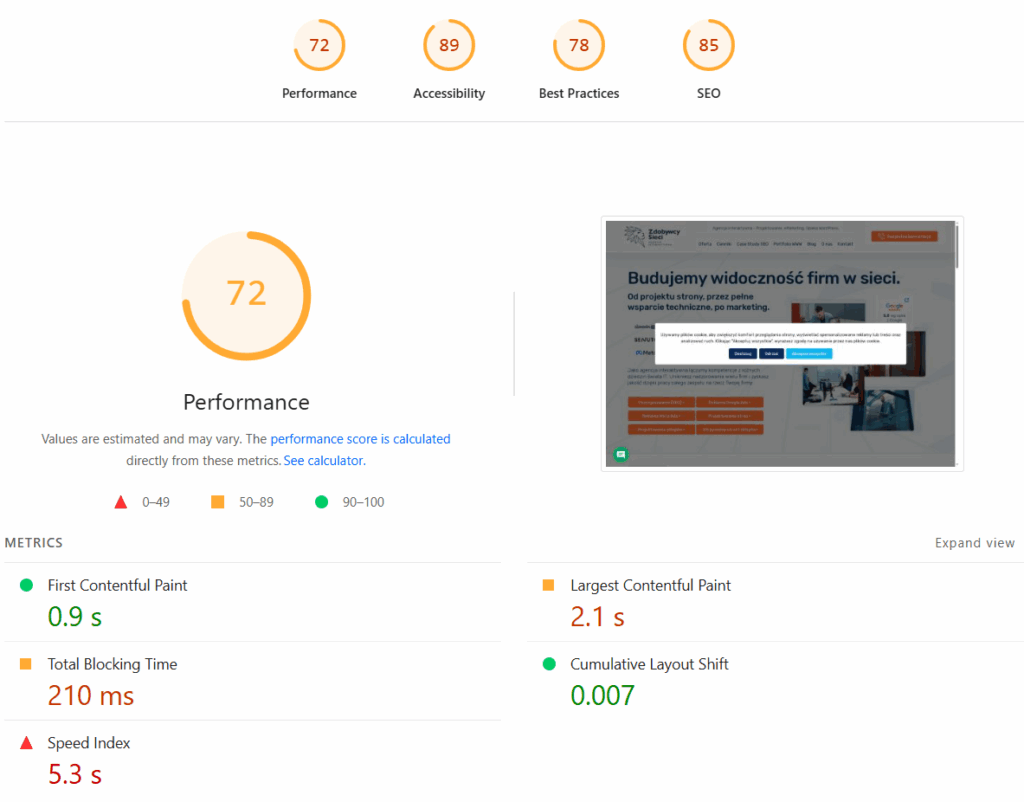

Prędkość wczytywania strony

Według raportu Google, aż 53% użytkowników opuszcza stronę mobilną, jeśli ładuje się dłużej niż 3 sekundy. To ważne także dla indeksacji – wolne serwisy bywają mniej chętnie odwiedzane przez roboty.

„Z naszych badań wynika, że 53% użytkowników prawdopodobnie opuści stronę mobilną, która wczytuje się dłużej niż trzy sekundy. Podejmij odpowiednie działania, by przyspieszyć wczytywanie swoich stron na urządzeniach mobilnych. Krótszy czas wczytywania zwiększa zaangażowanie użytkowników i może się przekładać na wyższe przychody”. – Google AdSense

Spam i podejrzane działania

Jeśli Twoja witryna była celem ataku hakerskiego lub zawiera treści spamowe, Google może wykluczyć ją z indeksu. W takich przypadkach pojawiają się ostrzeżenia w Google Search Console.

Najczęstsze powody:

- zainfekowanie strony szkodliwym oprogramowaniem;

- automatycznie generowane treści bez wartości;

- nadmierne nasycanie frazami (tzw. keyword stuffing).

Usunięcie takich problemów stanowi priorytet. Dopiero po oczyszczeniu serwisu i zgłoszeniu ponownej weryfikacji w Search Console można liczyć na powrót do indeksu.

Jak naprawić problemy z indeksacją?

Na tym etapie warto zebrać w całość najważniejsze działania:

- sprawdź plik robots.txt oraz meta tagi – usuń wszelkie blokady, jeśli nie są już potrzebne;

- przeanalizuj mapę strony i dodaj ją do Google Search Console – to sygnał dla robotów, które adresy mają odwiedzić;

- wykorzystaj narzędzie „Sprawdź URL” w Search Console – aby ręcznie zgłosić strony, które powinny trafić do indeksu;

- zadbaj o jakość treści – twórz artykuły unikalne, obszerne i dobrze ustrukturyzowane;

- skontroluj linkowanie wewnętrzne i zewnętrzne – dzięki temu robot szybciej dotrze do Twojej witryny;

- przeanalizuj logi serwera – sprawdzisz, jak Googlebot faktycznie odwiedza Twoją stronę;

- usuń błędy techniczne – problemy z przekierowaniami, kanonicznymi adresami czy błędy 500 potrafią skutecznie zatrzymać indeksację;

- sprawdź bezpieczeństwo – jeśli witryna została zainfekowana, zgłoś ją do ponownej weryfikacji po naprawie.

Chcesz, aby Twoja strona była widoczna, a proces indeksowania przebiegał bez przeszkód? Skontaktuj się z agencją Zdobywcy Sieci – przygotujemy dla Ciebie techniczną analizę, wdrożymy rozwiązania i poprowadzimy cały proces.